人工智能的发展给我们的生活带来很多不一样的体验。面部识别可以解锁设备,激光雷达可以实现自动驾驶。当2023年,OpenApi的chatGPT可以“理解”人类的语言并与我们进行沟通时,大语言模型的概念出现在我们面前。

在自然语言处理领域的大语言模型(Large Language Model)是参数数量庞大、能够处理复杂语言结构和语境的深度学习模型。

在自然语言处理领域的大语言模型(Large Language Model)是参数数量庞大、能够处理复杂语言结构和语境的深度学习模型。

OpenApi公司的大语言模型GPT-3有1750亿(175B)个参数。GPT-4的参数没有公开,预估有18000亿(1.8T)个参数,是GPT-3的十倍。Meta公司刚发布的Llama3有80亿(8B)个参数和700亿(70B)个参数两个版本,更大规模4000亿(400B)个参数的模型还在训练中。

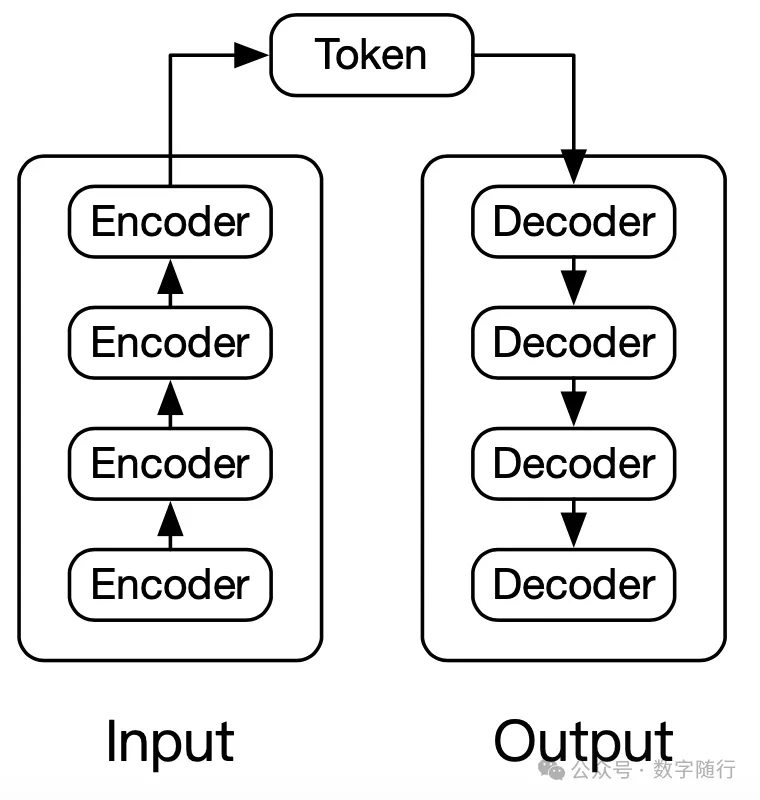

大语言模型更多是描述模型的规模和能力,并不限定实现的架构或训练方法。GPT是LLM中的一种具体实现,它采用Transformer架构,通过预训练和微调来学习通用语言。Transformer架构包含编码器(Encoder)和解码器(Decoder)两部分。GPT模型通过编码理解内容,然后再通过解码生成内容。

编码解码示意图

编码解码示意图

在使用大模型进行训练学习时,产生了一种新的现象,被称为涌现(emergence)。涌现原意是许多小实体相互作用后产生了大实体,而这个大实体展现了组成它的小实体所不具有的特性。在GPT模型训练过程中,涌现是模型学会了没有显示标注的技能、行为或特征,这些都是在大规模数据集进行训练时产生的特殊效果。在语义理解过程中,GPT模型可以理解和处理语言中复杂的语义关系,推断出逻辑关系和常识。在语言生成过程中,GPT模型可以生成与训练数据中不同的语言结构和居室,甚至创造出符合语法规则和语义逻辑的新短语或句子。

涌现给人们带来惊喜的同时也带来了新问题。生成错误信息:虽然进行训练的数据都是正确的信息,但是涌现生成的“新内容”可以认为是一种学习后的新成果,但是这种学习成果并没有经过验证就直接输出给用户。内容质量参差不齐:输出的结果质量不一致,不能让用户满意。可能涉及版权问题:模型的训练集通常会包含已有的文学作品、专利等,但是涌现出的结果可能与这些内容一样,但并未意识到内容已经涉嫌侵犯版权。

大语言模型并不是唯一一个通过提升数据规模而实现巨大变革的模型。在图像识别领域,大规模的图像训练集使卷积神经网络(CNN)算法在图片识别方面取得了质的飞跃。数据将成为我们迈向未来的新“能源”,为我们开启一个全新的时代。